La base de données d’IA DeepSeek dévoilée : plus d’un million de lignes de journal et des clés secrètes divulguées

La start-up chinoise d’intelligence artificielle (IA) DeepSeek , qui a connu une ascension fulgurante en popularité ces derniers jours, a laissé l’une de ses bases de données exposée sur Internet, ce qui aurait pu permettre à des acteurs malveillants d’accéder à des données sensibles.

La base de données ClickHouse « permet un contrôle total sur les opérations de la base de données, y compris la possibilité d’accéder aux données internes », a déclaré Gal Nagli, chercheur en sécurité chez Wiz .

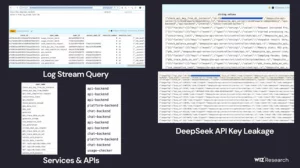

L’exposition comprend également plus d’un million de lignes de flux de journaux contenant l’historique des conversations, des clés secrètes, des détails du backend et d’autres informations extrêmement sensibles, telles que les secrets de l’API et les métadonnées opérationnelles. DeepSeek a depuis comblé la faille de sécurité après que l’entreprise de sécurité cloud a tenté de les contacter.

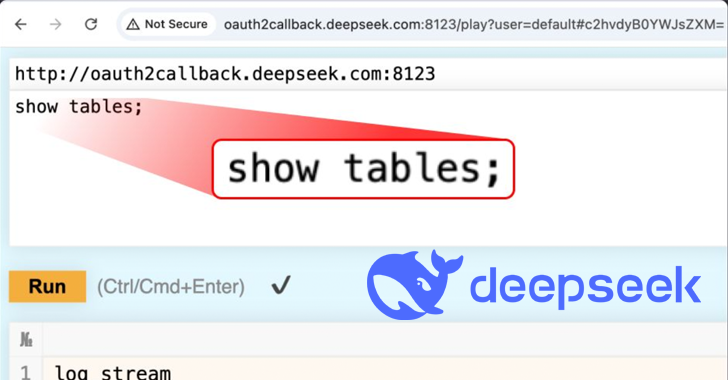

La base de données, hébergée sur oauth2callback.deepseek[.]com:9000 et dev.deepseek[.]com:9000, aurait permis un accès non autorisé à un large éventail d’informations. Selon Wiz, cette exposition a permis un contrôle complet de la base de données et une escalade potentielle des privilèges au sein de l’environnement DeepSeek sans nécessiter d’authentification.

L’opération consistait à exploiter l’interface HTTP de ClickHouse pour exécuter des requêtes SQL arbitraires directement via le navigateur Web. On ignore actuellement si d’autres acteurs malveillants ont saisi l’occasion d’accéder aux données ou de les télécharger.

« L’adoption rapide de services d’IA sans sécurité correspondante est intrinsèquement risquée », a déclaré Nagli dans un communiqué partagé avec The Hacker News. « Alors qu’une grande partie de l’attention autour de la sécurité de l’IA se concentre sur les menaces futuristes, les véritables dangers proviennent souvent de risques de base, comme l’exposition externe accidentelle de bases de données. »

« La protection des données clients doit rester la priorité absolue des équipes de sécurité, et il est essentiel que ces équipes travaillent en étroite collaboration avec les ingénieurs en IA pour protéger les données et empêcher toute exposition. »

DeepSeek est devenu le sujet de discussion du jour dans les cercles d’IA pour ses modèles open source révolutionnaires qui prétendent rivaliser avec les principaux systèmes d’IA comme OpenAI, tout en étant efficaces et rentables. Son modèle de raisonnement R1 a été salué comme « le moment Spoutnik de l’IA ».

DeepSeek est devenu le sujet de discussion du jour dans les cercles d’IA pour ses modèles open source révolutionnaires qui prétendent rivaliser avec les principaux systèmes d’IA comme OpenAI, tout en étant efficaces et rentables. Son modèle de raisonnement R1 a été salué comme « le moment Spoutnik de l’IA ».

Le chatbot IA du nouveau venu s’est hissé au sommet des classements des magasins d’applications sur Android et iOS sur plusieurs marchés, même s’il est devenu la cible d’« attaques malveillantes à grande échelle », l’incitant à suspendre temporairement les inscriptions.

Dans une mise à jour publiée le 29 janvier 2025, la société a déclaré avoir identifié le problème et qu’elle travaillait à la mise en œuvre d’un correctif.

Dans le même temps, l’entreprise a également fait l’objet d’un examen minutieux de ses politiques de confidentialité, sans parler de ses liens avec la Chine qui sont devenus un sujet de préoccupation pour la sécurité nationale des États-Unis.

Bloomberg , le Financial Times et le Wall Street Journal ont également rapporté qu’OpenAI et Microsoft cherchaient à savoir si DeepSeek avait utilisé l’interface de programmation d’application (API) d’OpenAI sans autorisation pour former ses propres modèles sur la sortie des systèmes d’OpenAI, une approche appelée distillation .

« Nous savons que des groupes en [Chine] travaillent activement à l’utilisation de méthodes, notamment ce que l’on appelle la distillation, pour tenter de reproduire les modèles avancés d’IA américains », a déclaré un porte-parole d’OpenAI au Guardian.